[1] Norm matters: efficient and accurate normalization schemes in deep networks

Elad Hoffer , Ron Banner , Itay Golan, Daniel Soudry

Technion - Israel Institute of Technology, Intel - Artificial Intelligence Products Group (AIPG)

过去几年,批归一化广泛应用于深层网络中,这种技巧可以加速训练过程,并且在多种应用中可以提升效果。但是这种技巧之所以带来好的效果的原因尚待探索,并且有一些缺陷阻碍了该技巧在某些任务中的应用。

这篇文章给出了归一化方法和权重衰减方法的目的及作用层面的新视角,将其视为优化目标中减弱权重范数的工具。这种特性可以凸显归一化,权重衰减以及学习率调整之间的联系。

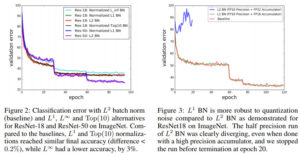

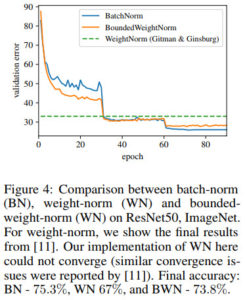

针对广泛应用的二范数的批归一化方法,这篇文章给出了几种替代方法,比如一范数的归一化,无穷范数的归一化,如此操作不仅可以降低计算复杂度和存储需求,而且可以显著提升数值稳定性,尽管准确率会低一些。

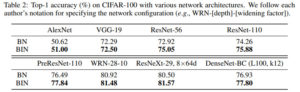

不同归一化方法的效果对比如下

代码地址

https://github.com/eladhoffer/norm_matters

[2] Batch-Instance Normalization for Adaptively Style-Invariant Neural Networks

Hyeonseob Nam, Hyo-Eun Kim

Lunit Inc.

图像识别中通常具有一些挑战性问题,比如纹理,光照条件等,这些视觉信息都会对图像识别带来挑战。尽管更多的训练数据和更深的网络似乎可以隐式解决这些变化的因素,图像风格迁移中的最近研究表明可以显式解决这种风格信息。

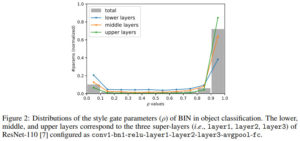

作者们将这种思想扩展到一般视觉识别问题中,提出批样例归一化方法对图像中不需要的风格进行归一化。在判别性任务中,特定的风格特征具有重要作用,批样例归一化方法可以在保持有用风格的前提下只对干扰性风格进行选择性的归一化。

本文所提出的归一化模块很容易融入到现有网络结构中,比如残差网络,同时在多种场景中都可以显著提升识别性能。

值得注意的是,批样例归一化方法在现有深度学习框架中只需要不多的行数即可实现。

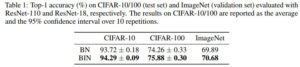

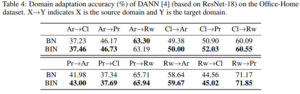

批归一化和批样例归一化在不同数据集上的效果对比如下

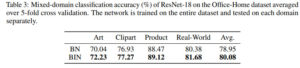

混合域分类效果对比如下

域适应效果对比如下

代码地址

https://github.com/hyeonseob-nam/Batch-Instance-Normalization

[3] Deep Reinforcement Learning of Marked Temporal Point Processes

Utkarsh Upadhyay, Abir De , Manuel Gomez-Rodrizuez

MPI-SWS

在很多应用中,人类在连续时间内都是通过异步随机的离散事件跟复杂的环境进行交互。在这种异步环境中,如何设计在线的交互来帮助我们实现特定的目标是一个问题。

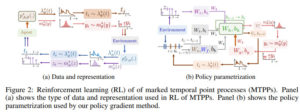

这篇文章从标记时序点过程中深度强化学习的角度来解决上面的问题,其中智能体的行为及其从环境中得到的反馈可以利用标记时序点过程来表征,具体是利用异步随机离散时间来实现。如此一来,可以利用意图和相应过程的标记分布来定义智能体的策略,然后可以衍生出一种弹性策略梯度方法,利用深层循环神经网络将智能体的行为和该行为所接受的反馈嵌入到实值向量。

本文所提出的方法对意图的函数形式和反馈的标记分布不做任何假设,并且该方法可以允许任何复杂回报函数。

代码地址

文章评论