[1] Step Size Matters in Deep Learning Kamil Nar, S. Shankar Sastry University of California, Berkeley 利用梯度下降算法训练神经网络时,能够得到离散的非线性的动态系统。此时,在训练过程中网络会收敛到不定的点,而不是固定的点,而且还依赖于初始状态。 在这些现象中,步长起到非常重要的作用。步长决定了局部最优解的子集,如果算法收敛到一个轨道上,步幅决定了在该轨道震动的幅度。为解释步长对神经网络的影响,作者们…

[1] Deep, complex, invertible networks for inversion of transmission effects in multimode optical fibres Oisín Moran, Piergiorgio Caramazza, Daniele Faccio, Roderick Murray-Smith University of Glasgow, University of Glasgow 这篇文章提出了一种基于复数域加权的深层网络,用于处理相干输…

[1] Evidential Deep Learning to Quantify Classification Uncertainty Murat Sensoy, Lance Kaplan, Melih Kandemir Ozyegin University, Adelphi, Robert-Bosch-Campus 确定性神经网络在很多机器学习任务中都能学到效果不错的预测器。然而,由于标准方法是训练网络使得预测误差最小,这种情况下得到的模型忽略了预测的置信度。贝叶斯神经网络通过权值的不确定性来间接地…

[1] KDGAN: Knowledge Distillation with Generative Adversarial Networks Xiaojie Wang, Rui Zhang, Yu Sun, Jianzhong Qi University of Melbourne, Twitter Inc. 这篇文章提出一种三个玩家的游戏,KDGAN,其中包含分类器,老师以及判别器。分类器和老师通过精炼损失函数来互相学习,并且二者是通过对抗式损失函数跟判别器之间是对抗式训练的。通过同时优化精炼损失函数…

Yixi Xu, Xiao Wang Purdue University 这篇文章针对加权正则的深层神经网络给出一种通用框架。该文给出了拉德马赫复杂度的上限。对于某种特殊的加权正则网络,近似误差可以由输出层的L1范数得以控制,并且对应的泛化误差只依赖于网络结构,具体而言即为深度的平方根。 这篇文章的主要贡献如下 不同情况的复杂度下限为 Karl Ridgeway, Michael C. Mozer University of Colorado and Sensory, In…

Jianlong Chang, Jie Gu, Lingfeng Wang, Gaofeng Meng, Shiming Xiang, Chunhong Pan Chinese Academy of Sciences, University of Chinese Academy of Sciences 这篇文章提出一种可以适用于具有一定结构的卷积神经网络,这种网络不仅可以处理欧氏距离的数据,也可以处理非欧氏距离的结构化数据。结构卷积算子可以将多种拓扑结构的数据聚合起来,并且利用函数逼近理…

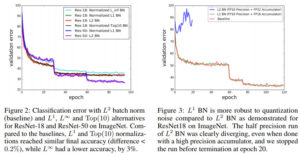

Elad Hoffer , Ron Banner , Itay Golan, Daniel Soudry Technion - Israel Institute of Technology, Intel - Artificial Intelligence Products Group (AIPG) 过去几年,批归一化广泛应用于深层网络中,这种技巧可以加速训练过程,并且在多种应用中可以提升效果。但是这种技巧之所以带来好的效果的原因尚待探索,并且有一些缺陷阻碍了该技巧在某些任务中的应用。 这篇文章给出了归…

Arash Vahdat , Evgeny Andriyash , William G. Macready Quadrant.ai, D-Wave Systems Inc. 在变分自编码(VAEs)中,波尔兹曼机分布在二值隐含变量中是一种有效的先验知识。但是,之前的一些训练离散变分自编码的方法利用的是证据下界,而不是紧致的重要性加权的界。 这篇文章提出两种方法将波尔兹曼机用于连续分布,并且保证训练时具有重要性加权的界。主要是利用泛化重叠变换和高斯积分技巧。 几种方法的效果对比如下 代码地址 https://gith…

截图1-300x92.jpg)

截图1-300x178.jpg)