[1] Unsupervised Video Object Segmentation for Deep Reinforcement Learning

Vik Goel, Jameson Weng, Pascal Poupart

University of Waterloo

立即下载

这篇文章给出一种新的技术,该方法可以使得深度强化学习自动监测移动的物体,还可以利用相关信息来选择动作。对运动物体的监测是通过无监督方式实现了,其中利用了运动的结构信息。

该方法并不是直接从原始图像中学习策略,智能体首先利用视频序列中的流信息来学习如何检测和分割移动的物体。所学到的表示可以使得智能体的策略集中在移动的物体上。随着时间的推移,智能体能够识别出对于决策起关键作用的物体,然后给予相关移动物体来逐渐构建策略。

作者们将这种方法称作面向运动的强化学习(MOREL),它可以监测运动的物体,进而降低了与环境交互的次数,而且可以得到好的策略。该方法相对另一种方法得到的策略解释性更强,另一种方法即利用黑箱神经网络直接就爱你个图像映射到行动或者映射到价值。

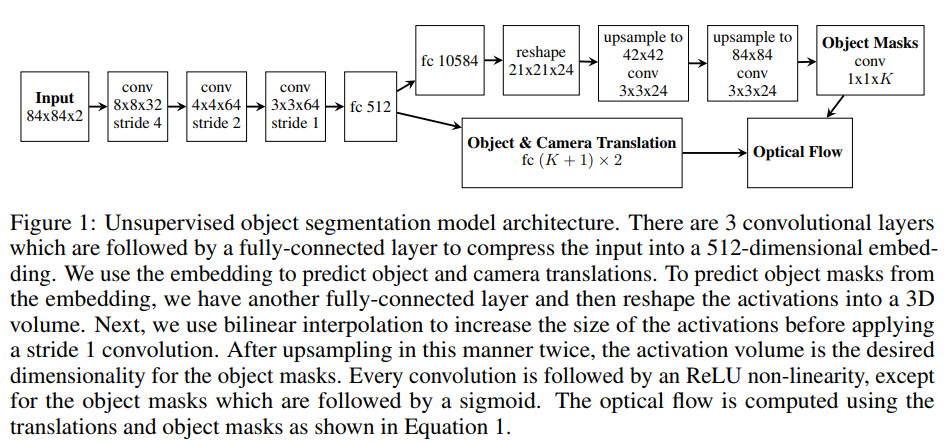

无监督物体分割模型的结构示例如下

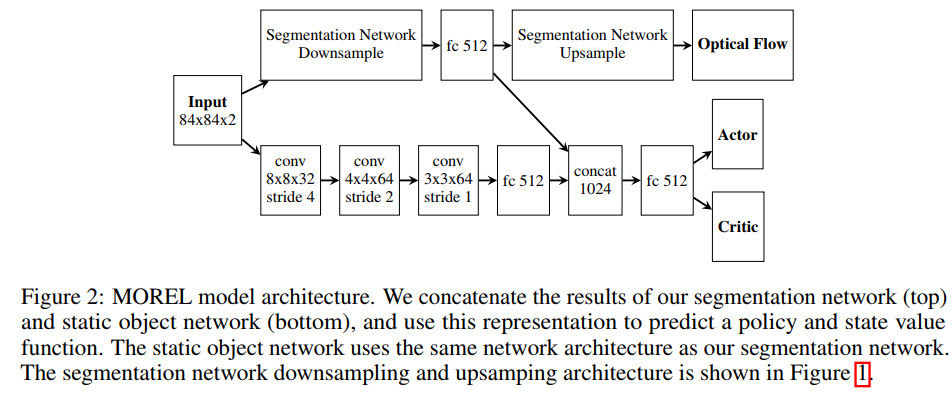

本文所提出的模型结构示意图如下

代码地址

https://github.com/vik-goel/MOREL

[2] Critical initialisation for deep signal propagation in noisy rectifier neural networks

Arnu Pretorius, Elan Van Biljon, Steve Kroon, Herman Kamper

Stellenbosch University

立即下载

随机正则在深度学习中非常重要,但是,噪声如何影响深度学习中的信号传播仍然有待探索。

这篇文章基于平均场理论,提出了一种新的框架,用于研究随机正则神经网络的信号传播。作者们提出的噪声信号传播理论可以融合多种常见的噪声分布,比如加乘高斯噪声,dropout等。利用该框架可以探索含噪声ReLU网络的初始化策略。

利用加性噪声时,并没有严格的初始策略,尽管事先选定了噪声分布,信息传播时依然会暴增。对于乘性噪声,比如dropout,作者们发现一种关键的初始化策略,该策略依赖于噪声分布的二次矩。

实验表明,作者们提出的初始化策略可以使得深度学习中的信号传播比较稳定,而不考虑噪声的初始化方法就做不到这点。强噪声正则可以降低含噪声ReLU网络输入的判别性信息传播的深度,即使初始化时比较严格。

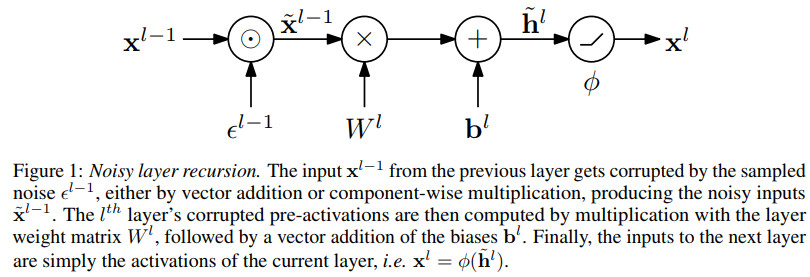

误差层递推示例如下

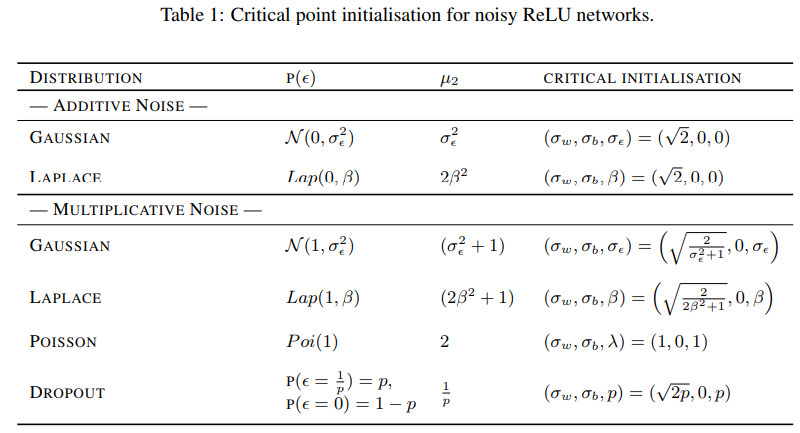

不同噪声情况下初始化方法对比如下

代码地址

https://github.com/ElanVB/noisy_signal_prop

[3] CapProNet: Deep Feature Learning via Orthogonal Projections onto Capsule Subspaces

Liheng Zhang† , Marzieh Edraki† , and Guo-Jun Qi

University of Central Florida, Huawei Cloud

立即下载

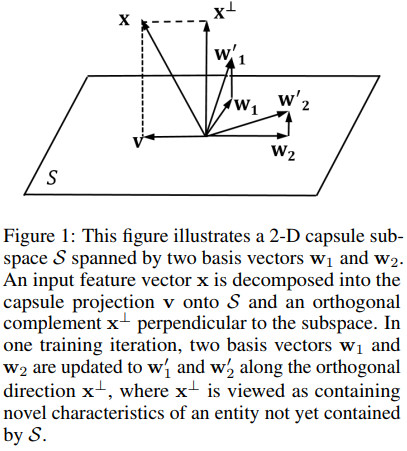

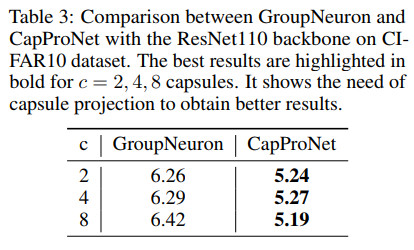

这篇文章提出一种关于胶囊网络的新思想,即利用胶囊向量而不是神经元的激活来预测样本的标签。首先将输入特征向量投影到一组胶囊子空间上,然后利用所得胶囊网络的长度得到样本属于各个类别的概率。这种网络称为胶囊投影网络(CapProNet),在每个胶囊子空间中,都可以学习一个正交的投影矩阵,每个胶囊子空间不断更新,直至该子空间包含了相应类别的输入样本对应的特征向量。

胶囊投影可以看做对权重矩阵的多个列进行归一化,同时得到正交基,这就可以将输入特征的新成分融合起来,进而更新胶囊表示。胶囊投影可以看做胶囊子空间的多维权重归一化,传统的权重归一化是胶囊投影在一维上的特例。在低维胶囊子空间中训练或者利用另外一种比较强大的迭代来估计归一化矩阵,会带来一些额外的计算量,但是这些计算量可以忽略。

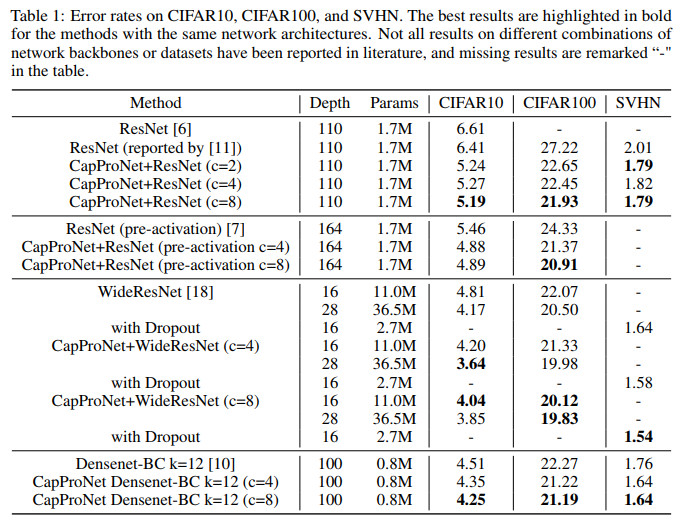

这种方法可以使得ResNet效果提升10-20%,能够使得Densenet效果提升5-7%,同时保证了计算复杂度和存储需求的量级不变。在一些基准数据集上,CapProNet可以使得胶囊网络的测试误差显著下降。

2维的胶囊投影示例如下

多种方法在CIFAR10, CIFAR100, SVHN这三个数据集上的效果对比如下

其中ResNet对应的论文为

Deep residual learning for image recognition, CVPR 2016

代码地址

https://github.com/KaimingHe/deep-residual-networks

Deep networks with stochastic depth, ECCV 2016

代码地址

https://github.com/yueatsprograms/Stochastic_Depth

Identity mappings in deep residual networks, ECCV 2016

代码地址

https://github.com/tornadomeet/ResNet

WideResNet对应的论文为

Wide residual networks

代码地址

https://github.com/szagoruyko/wide-residual-networks

Densenet-BC对应的论文为

Densely connected convolutional networks, CVPR 2017

代码地址

https://github.com/liuzhuang13/DenseNet

与GroupNeuron对比如下

代码地址

https://github.com/maple-research-lab

文章评论